Wege zur KI-Validierung

Compliance-Ansätze zum Einsatz von KI im regulierten Pharma-Umfeld

Compliance-Ansätze zum Einsatz von KI im regulierten Pharma-Umfeld

Der Einsatz von künstlicher Intelligenz spielt eine wachsende Rolle in der Pharmaindustrie. Seit 2015 sind die KI-bezogenen Investitionen um das 27-fache gestiegen. Diese Entwicklung betrifft nicht nur die Arzneimittelforschung, sondern auch den Produktionsprozess. So werden bereits heute KI-Systeme zur Überwachung von Produktionsparametern oder in der optischen Qualitätskontrolle eingesetzt, etwa um beim Vier-Augen-Prinzip ein Augenpaar zu ersetzen.

Diesen Potenzialen stehen jedoch große Unsicherheiten im regulierten Umfeld, beispielsweise bei der Validierung computergestützter Systeme gegenüber: klassische Validierungsverfahren wie das V-Modell sind für KI-Systeme nicht mehr geeignet. Klare regulatorische Vorgaben fehlen oder befinden sich erst in der Entstehung. Sowohl Behörden als auch Unternehmen stehen somit vor der Herausforderung, neue Ansätze für einen verlässlichen Einsatz von KI im regulierten Umfeld zu finden.

GxP-Relevanz ausschlaggebend für regulative Anforderungen

Der Grad der anwendbaren regulatorischen Anforderungen hängt davon ab, wo und wie KI-Lösungen eingesetzt werden: Daher sollte zunächst der Einsatzbereich der geplanten KI-Lösung (Intended Use) definiert werden, indem die konkreten Herausforderungen bzw. Probleme beschrieben werden, die durch den Einsatz von ML/AI gelöst werden sollen.

Aus regulatorischer Sicht sind dabei zwei Punkte entscheidend: Zum einen die Frage, ob der durch das ML/AI-System unterstützte Prozess direkt oder indirekt die Qualität, Sicherheit oder Wirksamkeit von Arzneimitteln oder Medizinprodukten beeinflusst – und damit als GxP-kritisch einzustufen ist. Zum anderen ist zu klären, welche Kontrollinstanzen die ML/AI-Systeme überwachen bzw. welche Kontrollinstanzen die ML/AI-Systeme ersetzen oder ergänzen. ML/AI-Systeme können bestimmte menschliche Überwachungsfunktionen automatisieren oder verbessern, sollten aber nicht als Ersatz für menschliche Verantwortung angesehen werden.

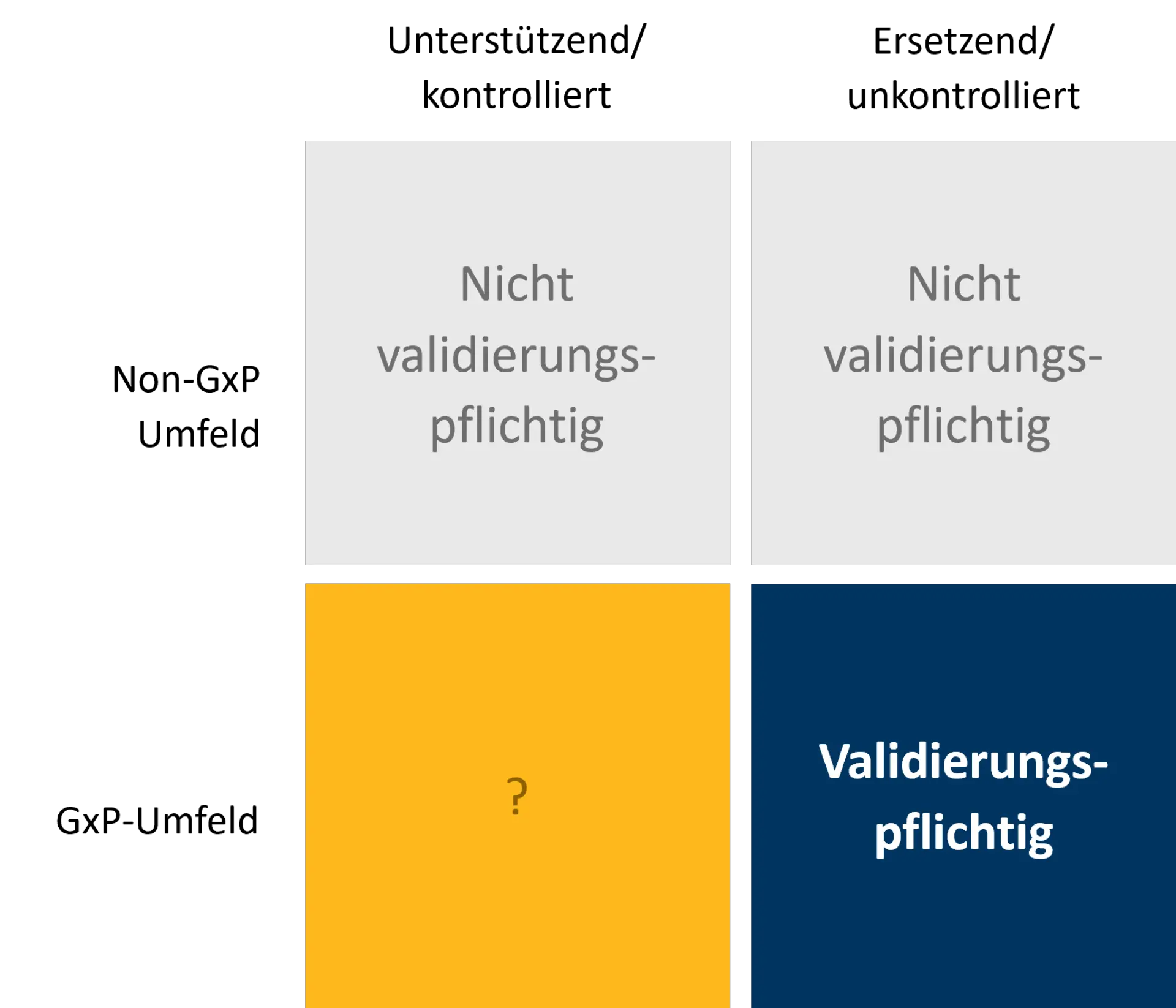

Je nach Klassifizierung ergeben sich unterschiedliche regulatorische Anforderungen, z. B. hinsichtlich der Validierungspflicht. Folgende Grundtypen können dabei unterschieden werden:

Schema zur Bewertung der Validierungspflicht für AI ML Anwendungen im Pharma Umfeld

Absicherung von ML/AI-Systemen im regulierten Umfeld

Heute finden sich im GxP-Umfeld fast ausschließlich Systeme, die durch zusätzliche, menschliche, Kontrollinstanzen oder nachgelagerte Freigabeprozesse abgesichert und damit nicht validierungspflichtig sind. Umgekehrt gibt es für validierungspflichtige KI-Lösungen in GxP-relevanten Prozessen aufgrund fehlender Richtlinien bislang keine standardisierte Vorgehensweise zur Implementierung. In beiden Fällen empfiehlt sich jedoch ein Ansatz, der die folgenden Schritte berücksichtigt:

1. Formulierung von Akzeptanzkriterien

Akzeptanzkriterien bilden die Grundlage für den Validierungsprozess, indem sie objektive und messbare Kriterien liefern, anhand derer beurteilt werden kann, ob das System entsprechend den spezifischen Anforderungen der geplanten Anwendung funktioniert und unter gleichen Bedingungen immer das gleiche Ergebnis liefert. Für KI-Systeme die nicht-deterministische Ergebnisse liefern sollen, kann das Akzeptanzkriterium nicht festgeschrieben sein, sondern sollte messbar, aber dynamisch sein (bspw.: „bei optischen Kontrollen muss die KI ein besseres Ergebnis (False rejection/acceptance rate) liefern als das klassische System oder der Mensch“). Im Kontext der KI-Validierung treten dabei zunehmend statistische Betrachtungen zu „Wirksamkeit und Nebenwirkungen“ an die Stelle binärer Aussagen. Hier könnten sich somit Synergien zwischen klassischer Arzneimittelforschung und KI-Validierung ergeben.

2. Erstellung von ML/AI-SOPs

Die Erstellung von Standard Operating Procedures (SOP) ist für den sicheren Betrieb von ML/AI-Systemen unerlässlich. Sie liefern verbindliche Beschreibungen der notwendigen Prozesse und Abläufe und legen Verantwortlichkeiten und Vorgehensweisen fest, einschließlich der Überprüfung der Ergebnisse und deren Dokumentation. Dabei sind die spezifischen Anforderungen und Eigenschaften des jeweiligen KI-Systems zu berücksichtigen und entsprechend angepasste SOPs zu entwickeln. Folgende Definitionen sollten darin enthalten sein:

- Verantwortlichkeiten für Implementierung und Betrieb

In den SOPs sollte klar festgelegt werden, welche Personen oder Teams für die Implementierung und den Betrieb der ML/AI-Systeme verantwortlich sind. Dies schließt die Zuweisung von Aufgaben und Zuständigkeiten ein, um sicherzustellen, dass alle Aspekte der ML/AI-Systeme ordnungsgemäß berücksichtigt werden. - Art und Häufigkeit des Monitorings

Um sicherzustellen, dass ML/AI-Systeme ordnungsgemäß funktionieren und die gewünschten Ergebnisse liefern, müssen Art und Häufigkeit der Überwachung festgelegt werden. Dazu können auch die regelmäßige Überprüfung der Algorithmen, der Leistungsmetriken und der Datenintegrität gehören. - Risikoklassifizierung und -mitigierung

Darüber hinaus sollten die SOPs auch eine Risikoklassifizierung der ML/AI-Systeme enthalten und entsprechende Maßnahmen zur Risikominderung definieren. Dies könnte eine Einteilung der Risiken in verschiedene Kategorien beinhalten, wie z. B. Risiken für die Patientensicherheit oder die Datenintegrität. Grundlage hierfür ist eine detaillierte Risikoanalyse (siehe nächster Punkt).

3. Durchführung einer detaillierten Risikoanalyse

Jede ML/AI-Implementierung birgt potenzielle Risiken, die sorgfältig bewertet werden müssen. Dabei stehen folgende Fragestellungen im Vordergrund:

- Welches Risiko ist tragbar?

Im ersten Schritt sollten Unternehmen ihre Risikotoleranz festlegen, indem sie bestimmen, welches Risikoniveau im Zusammenhang mit den jeweiligen ML-/AI-Systemen akzeptabel ist und welche Risiken vermieden oder reduziert werden müssen. Eine transparente Kommunikation über diese Risikotoleranz zwischen den für das KI-System Verantwortlichen, den Qualitätsverantwortlichen und dem Management ist entscheidend, um die Erwartungen zu klären und ein angemessenes Risikomanagement zu gewährleisten. - Welche AI-Autonomie erlaubt der Prozess?

Die Autonomie des ML/AI-Systems, d.h. der Grad der Selbststeuerung und Entscheidungsfindung, muss klar definiert werden. Je nach Anwendungsbereich und Risikotoleranz können ML/AI-Systeme mehr oder weniger autonom sein. Wichtig ist, dass die zugrundeliegenden Algorithmen und Entscheidungsprozesse transparent sind und von den Stakeholdern verstanden werden. - Welche potenziellen Fehlerquellen beeinflussen die Sicherheit des ML/AI-Systems?

Eine Failure Mode and Effects Analysis (FMEA) kann bei der Bewertung der Risiken im Zusammenhang mit der Reife des ML/AI-Systems, seiner Autonomie und der Datenqualität hilfreich sein. Durch die Identifizierung potenzieller Ausfallmodi, ihrer Auswirkungen und Ursachen können geeignete Maßnahmen zur Risikominderung entwickelt werden. Dazu gehören die Implementierung von Qualitätskontrollen, die regelmäßige Überprüfung und Aktualisierung der Algorithmen sowie die Sicherstellung einer kontinuierlichen Verbesserung der Datenqualität (siehe nächster Punkt).

Eine gründliche Risikoanalyse, die diese Aspekte berücksichtigt, ermöglicht es Unternehmen, die potenziellen Risiken von ML/AI-Implementierungen zu verstehen und geeignete Maßnahmen zur Risikominderung zu ergreifen. Obwohl die Risiken im Wesentlichen die gleichen sind wie bei herkömmlichen Systemen, sind die technischen Ursachen nicht oder nur schwer abschätzbar. Dies ist bei der Bewertung zu berücksichtigen.

4. Sicherstellung der Datenqualität

Die Qualität und Repräsentativität der Trainingsdaten sind entscheidend für die Leistungsfähigkeit und Robustheit des ML/AI-Modells. Um eine realistische Abbildung des Anwendungsbereichs zu gewährleisten, sollten daher Maßnahmen festgelegt werden, die sicherstellen, dass die Trainingsdaten ausreichend groß, vielfältig und frei von Verzerrungen sind. Dies erfordert eine gründliche Analyse und Bereinigung der Daten sowie die Auswahl geeigneter Metriken zur Bewertung der Datenqualität.

Die Validierung der Trainingsdaten sollte in einem strukturierten, dokumentierten und nachvollziehbaren Prozess erfolgen. Dazu gehören die Beschreibung der Datenerhebungsmethoden, die Überprüfung der Daten auf Fehler oder Ungenauigkeiten, die Dokumentation der Datenverarbeitungsschritte und die Analyse der Datenverteilungen und -statistiken. Darüber hinaus sollten Validierungstests durchgeführt werden, um die Leistung des ML/AI-Modells auf den Trainingsdaten zu bewerten und sicherzustellen, dass es die erwarteten Ergebnisse liefert.

Weiterführende Herausforderungen im Kontext unkontrollierter Systeme

Neben den beschriebenen allgemeinen Schritten zur Gewährleistung eines sicheren und Compliance-konformen Betriebs von ML/AI-Systemen ergeben sich besondere Herausforderungen im Umgang mit unkontrollierten Systemen (vgl. Abb. 1): Dies betrifft zum einen die eingesetzten Cloud-Systeme, die durch Änderungen der Hyperscaler beeinflusst werden und damit die Performance, Sicherheit oder Funktionalität der KI-Lösung beeinträchtigen können. Unternehmen müssen ihre Systeme folglich kontinuierlich überwachen, um unerwünschte Auswirkungen solcher Änderungen zu erkennen und zu beherrschen.

Zum anderen stehen gerade selbstlernende Systeme der Anforderung an computergestützte Systeme im GxP-Umfeld, transparente, nachvollziehbare und reproduzierbare Ergebnisse zu produzieren, diametral entgegen. Denn durch die ständige Weiterentwicklung des eigenen Modells kann es dazu kommen, dass Berechnungen mit gleichen Eingabedaten im Laufe der Zeit unterschiedlich ausfallen. Dieses nicht-deterministische Verhalten erschwert die Anwendung eines klassischen Validierungsansatzes, der sich an statischen Akzeptanzkriterien orientiert. Vor diesem Hintergrund müssen Unternehmen neue Mechanismen finden, um unerwünschtes Verhalten zu erkennen und zu korrigieren, sobald es auftritt. Derzeit verfügbare KI/ML-Lösungen umgehen diese Problematik, indem sie statische Systeme verwenden, bei denen der Lernprozess des Systems bereits vor dem produktiven Einsatz abgeschlossen ist.

Fazit

Der Einsatz von KI im regulierten Umfeld der Pharmaindustrie bietet große Potenziale für Innovation und Effizienzsteigerung, stellt aber gleichzeitig hohe Anforderungen an den sicheren und regelkonformen Betrieb der Systeme. Insbesondere die Implementierung autonomer Systeme bereitet den Unternehmen derzeit noch große Schwierigkeiten, da bislang keine Richtlinien für die Validierung entsprechender Lösungen existieren. Dennoch sollten sich Unternehmen bereits jetzt mit den Anforderungen und Möglichkeiten der Validierung von KI-Systemen auseinandersetzen. Denn die etablierten Regularien befinden sich im Umbruch – Behörden wie die FDA fordern die Industrie zur engen Zusammenarbeit auf. Wer hier frühzeitig aktiv wird, kann sich Wettbewerbsvorteile sichern.

Auf dem Weg dorthin müssen Unternehmen zunächst verstehen, von welchen regulatorischen Anforderungen sie überhaupt betroffen sind, und dann geeignete Maßnahmen ergreifen, um die Sicherheit von KI-Systemen zu gewährleisten. Eine systematische Herangehensweise, die auf den Prinzipien der Computersystem-Validierung basiert, bildet dafür die ideale Grundlage.

Autoren

Sie möchten mehr über dieses Thema erfahren oder individuelle Herausforderungen diskutieren?

Unsere Ansprechpartner stehen Ihnen gerne für ein persönliches Gespräch zur Verfügung.