„KI verändert nicht die Ziele von CSV, sondern vielmehr die Art der Kontrolle.“

CSV Trends 2026

Ein Interview mit unserer Expertin Sabine Komus

Was bedeutet risikobasierte CSV und in welchem Umfang ist dieser Ansatz in Organisationen bereits etabliert?

In der Praxis bedeutet risikobasierte CSV vor allem eines: nicht mehr alles gleich zu behandeln. Genau hier liegen die Defizite vieler Organisationen. In der Theorie ist das Konzept verstanden, in der Praxis agieren Unternehmen bei der Validierung jedoch häufig weiterhin sehr vorsichtig. Das zeigt sich in wiederkehrenden Mustern: Entscheidungen werden aus Angst vor Audits eher vermieden als begründet, und der Dokumentationstiefgang unterscheidet sich kaum zwischen kritischen und unkritischen Funktionen. Das Ergebnis ist eine Situation, in der Risiken zwar bewertet werden, jedoch keine echte Steuerungswirkung entfalten.

Risikobasierte CSV bedeutet genau das – nicht nur testen, sondern auch aktiv mitsteuern. Dafür braucht es den Mut, fundierte Entscheidungen zu treffen und diese auch in Audits zu vertreten. Um dies zu ermöglichen, müssen die organisatorischen Voraussetzungen geschaffen und Verantwortlichkeiten klar definiert werden. Zudem ist eine Unternehmenskultur erforderlich, in der risikobasierte Entscheidungen akzeptiert und von allen getragen werden. Gelingt dies, lässt sich das Potenzial von CSV ausschöpfen: weniger Overengineering, deutlich geringerer Aufwand und eine Validierung, die sich an der Realität moderner IT orientiert.

Sie betonen die wachsende Bedeutung des lebenszyklusorientierten Denkens in der CSV. Wo liegt die Herausforderung bei der nachhaltigen Etablierung?

Zunächst einmal ist lebenszyklusorientierte CSV kein neues Konzept – neu ist vielmehr der Druck, es konsequent umzusetzen. In der Praxis scheitert dies weniger an fehlendem Wissen als an einer mangelnden operativen Verankerung. CSV muss dort stattfinden, wo Systeme tatsächlich gesteuert werden, insbesondere im Change-, Release- und Incident-Management sowie in der Zusammenarbeit mit Cloud- und SaaS-Anbietern. Vor allem aber muss dies während des laufenden Betriebs erfolgen.

Die eigentliche Aufgabe – und zugleich die immer wiederkehrende Herausforderung – besteht darin, bestehende Konzepte handhabbar und konsistent zu machen. Das bedeutet, sehr praktische Fragen zu beantworten: Was bedeutet ein „validierter Zustand“ nach dem zehnten Release? Welche Änderungen erfordern tatsächlich eine formale Validierung? Wie bleibt der Aufwand beherrschbar? Dafür braucht es keine neuen Prozesse, sondern klare, pragmatische Regeln, risikobasierte Entscheidungshilfen und CSV-Konzepte, die im Alltag funktionieren und nicht nur auf dem Papier.

Welche Auswirkungen hat Künstliche Intelligenz auf den klassischen Validierungsansatz, und welchen Veränderungsdruck erzeugt sie?

Künstliche Intelligenz verändert nicht die Ziele der CSV, sondern die Art der Kontrolle. Entscheidend ist ein realistischer Umgang mit den Risiken von KI. Weder übertriebener Aktionismus noch starre Blockaden führen zum Ziel. Konkret bedeutet das: Klassische Tests bleiben relevant und wichtig, reichen jedoch allein nicht mehr aus. KI-Systeme bringen zusätzliche Risiken mit sich, etwa durch lernendes Verhalten, Datenabhängigkeiten oder Modellveränderungen im Zeitverlauf.

Deshalb muss Validierung in mehreren Bereichen erweitert werden – insbesondere durch Governance- und Monitoring-Konzepte, Performance- und Datenqualitätsüberwachung sowie durch klar definierte Grenzen für den Einsatz der Systeme und deren Einfluss auf Entscheidungslogiken und Entscheidungsprozesse. Der erste Schritt sollte daher eine klare Klassifizierung von KI-Anwendungsfällen sein, gefolgt von eindeutig definierten Verantwortlichkeiten und einer gezielten Weiterentwicklung bestehender CSV- und Datenintegritätsprinzipien. Meine Erfahrung zeigt: Unternehmen, die diese Themen frühzeitig und konsequent adressieren, gehen deutlich entspannter in Audits.

Risikobasierte Validierung in einer reifenden regulatorischen Landschaft

Die Computer System Validation (CSV) entwickelt sich kontinuierlich weiter, da regulierte Umgebungen zunehmend auf Cloud-Technologien, agile Bereitstellungsmodelle und Software-as-a-Service-Lösungen setzen. Bis 2026 spiegelt CSV zunehmend eine reife, risikobasierte und lebenszyklusorientierte Disziplin wider – aufbauend auf etablierten Prinzipien und einer starken regulatorischen Ausrichtung, während gleichzeitig die wachsende System- und Datenkomplexität adressiert wird und der Fokus verstärkt auf Daten, Algorithmen und Lifecycle-Kontrolle liegt.

Gleichzeitig führen Künstliche Intelligenz (KI) und personalisierte Medizin neue Systemeigenschaften und Datenabhängigkeiten ein. Insgesamt sind für 2026 keine disruptiven Veränderungen im CSV-Umfeld zu erwarten, wohl aber eine konsequente Weiterentwicklung hin zu einer risikobasierten, lebenszyklusorientierten Validierung. Organisationen, die in diesem Umfeld erfolgreich sind, wenden etablierte CSV-Prinzipien pragmatisch an, integrieren Validierung in moderne IT- und Datenarchitekturen und verstehen Datenintegrität als eine durchgängige End-to-End-Verantwortung.

Welche Entwicklungen werden also den CSV-Kontext in den kommenden Monaten prägen?

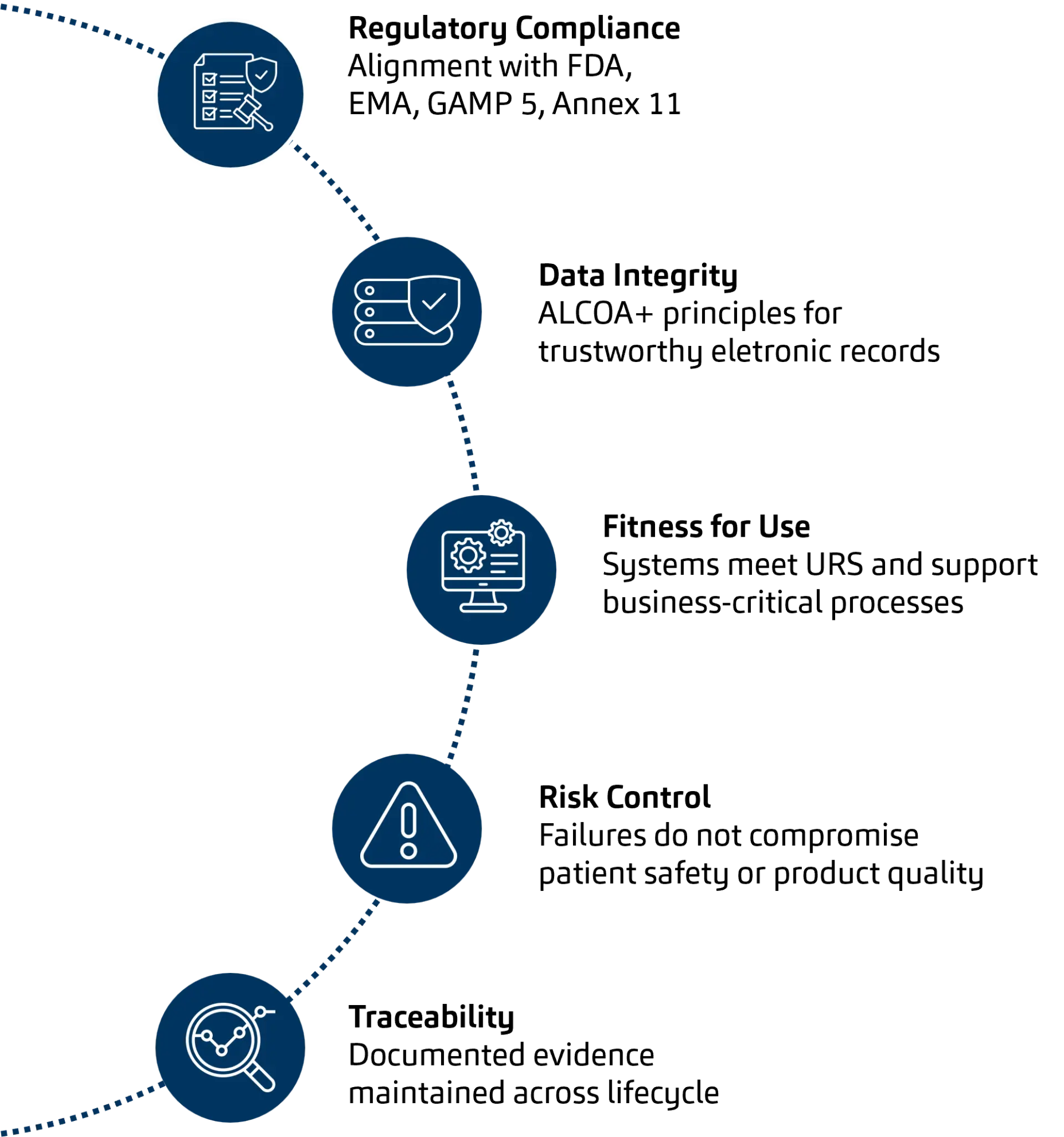

1. Risikobasierte CSV und Datenintegrität als etablierte Grundlage

Risikobasiertes Denken ist fest in der modernen CSV verankert und bildet weiterhin deren Fundament. Der Fokus liegt dabei insbesondere auf drei Bereichen: dem Schutz der Patientensicherheit, der Sicherstellung der Produktqualität und der Gewährleistung der Datenintegrität. Letztere verdient besondere Aufmerksamkeit, da sie – trotz technologischer Veränderungen – zunehmend zum Dreh- und Angelpunkt sowie Rückgrat aller CSV-Programme wird.

ALCOA+-Prinzipien, Audit-Trails, Zugriffskontrollen, Datenherkunft (Data Provenance) und Cybersecurity-Maßnahmen schaffen Vertrauen in validierte Systeme und ermöglichen Innovation.

Leitlinien von ISPE, die zweite Edition von GAMP 5 sowie der sich weiterentwickelnde regulatorische Rahmen (einschließlich des Entwurfs zur Überarbeitung von EU Annex 11) betonen konsequent einen verhältnismäßigen, pragmatischen und risikoorientierten Validierungsansatz. Anstatt neue Konzepte einzuführen, stärken diese Rahmenwerke die Kernziele der Softwarevalidierung in GxP-Umgebungen, die technologieübergreifend stabil bleiben.

2. Cloud & SaaS: Reife Validierungsansätze

Für cloudbasierte und SaaS-Lösungen haben sich CSV-Praktiken weitgehend stabilisiert. Dazu zählen insbesondere die Lieferantenqualifizierung als zentrale Validierungsaktivität, klar definierte Modelle geteilter Verantwortung sowie eine Validierung mit Fokus auf Konfiguration, Schnittstellen und den vorgesehenen Einsatzzweck.

CSV unterstützt zunehmend häufige Releases, Patches und Continuous Delivery durch Governance, Change Management und Lifecycle-Kontrollen.

3. KI-Systeme: Erweiterung bestehender CSV-Prinzipien

KI-gestützte Systeme erweitern CSV-Prinzipien um neue Dimensionen, darunter lernendes Verhalten, Model Drift, Erklärbarkeit und Performance-Monitoring. Die klassische testbasierte Validierung wird durch prozedurale, organisatorische und überwachende Kontrollen ergänzt, um die fortlaufende Eignung für den vorgesehenen Zweck sicherzustellen.

4. Personalisierte Medizin & datenzentrierte Validierung

Die personalisierte Medizin erhöht die System- und Datenkomplexität erheblich durch die Integration klinischer, genomischer und Real-World-Daten. CSV verlagert sich dabei von der Validierung einzelner Systeme hin zur Sicherstellung von End-to-End-Datenintegrität, Rückverfolgbarkeit und Prozesskontrolle über komplexe Datenflüsse hinweg.

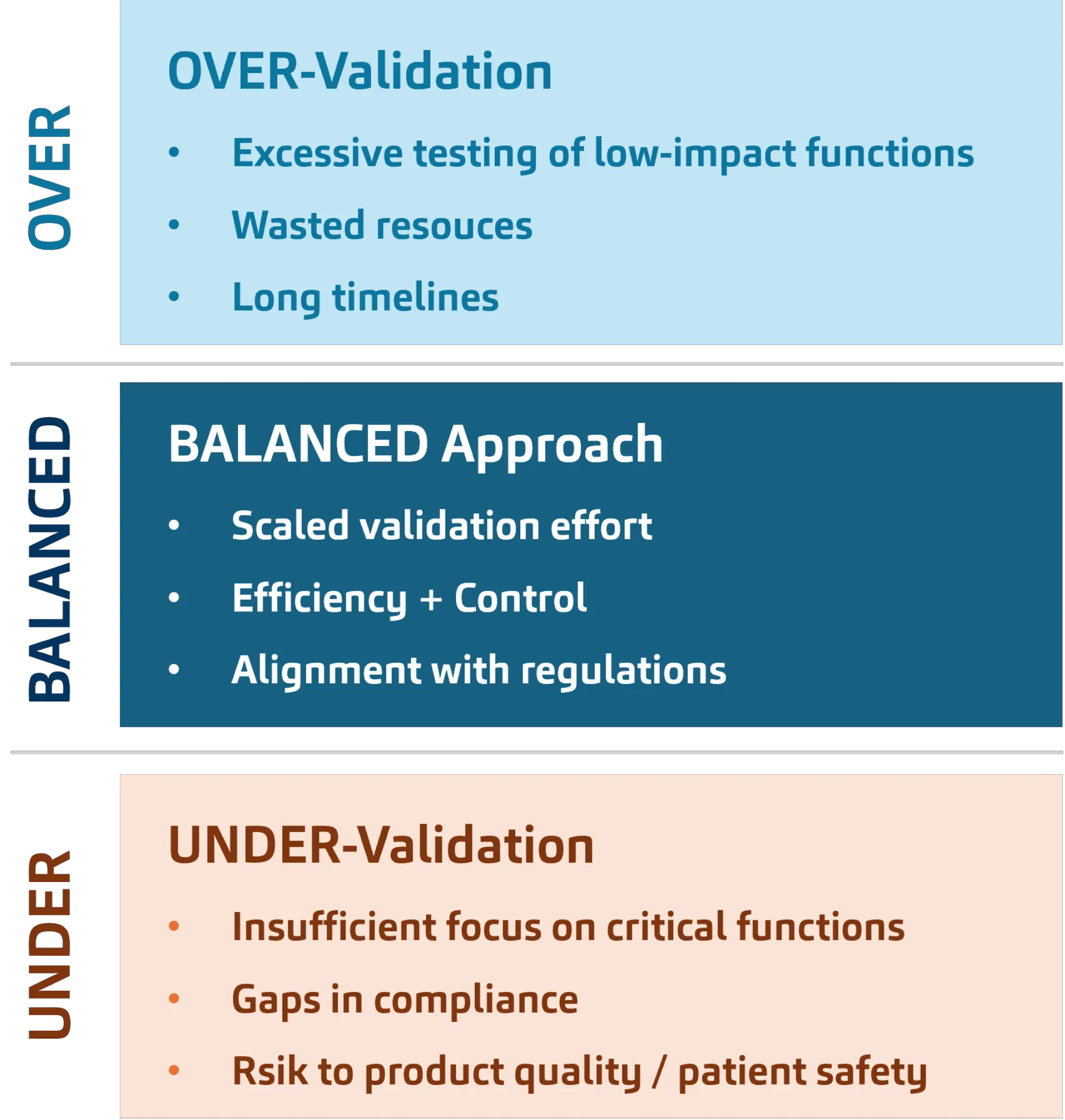

5. Lifecycle-Denken und das richtige Maß an Validierung

CSV wird zunehmend als kontinuierliche, lebenszyklusorientierte Disziplin verstanden, die fest in Change- und Release-Management eingebettet ist. Eine Validierungsstrategie muss so gestaltet sein, dass typische Risiken im Validierungsprozess vermieden werden. Dazu zählen einerseits Übervalidierung, die vor allem durch übermäßiges Testen von Funktionen mit geringer Auswirkung entsteht und zu langen Durchlaufzeiten sowie Ressourcenverschwendung führt. Das andere Extrem ist Untervalidierung, bei der der Fokus auf kritische Funktionen fehlt, Compliance-Lücken entstehen und vor allem Risiken für Patientensicherheit und Produktqualität erzeugt werden.

Autoren

Sie möchten mehr über dieses Thema erfahren oder individuelle Herausforderungen diskutieren?

Unsere Ansprechpartner stehen Ihnen gerne für ein persönliches Gespräch zur Verfügung.